1. AI大模型的“记忆难题”:长上下文推理的瓶颈与突破

当前AI大模型正朝着“超长记忆”方向快速演进,无论是处理百万行代码的开发场景、生成两小时连贯视频的创作需求,还是分析完整基因组序列的科学研究,都需要模型一次性理解和处理数百万Token的上下文。然而,传统GPU在面对这类任务时往往力不从心——上下文窗口超过10万Token后,推理速度会断崖式下降,内存带宽成为致命瓶颈,甚至出现“记前忘后”的连贯性问题。2025年9月10日,英伟达在AI基础设施峰会上发布的Rubin CPX GPU,正是瞄准这一核心痛点而来,试图通过硬件革新与架构重构,为AI推理打开“超长上下文”的大门。

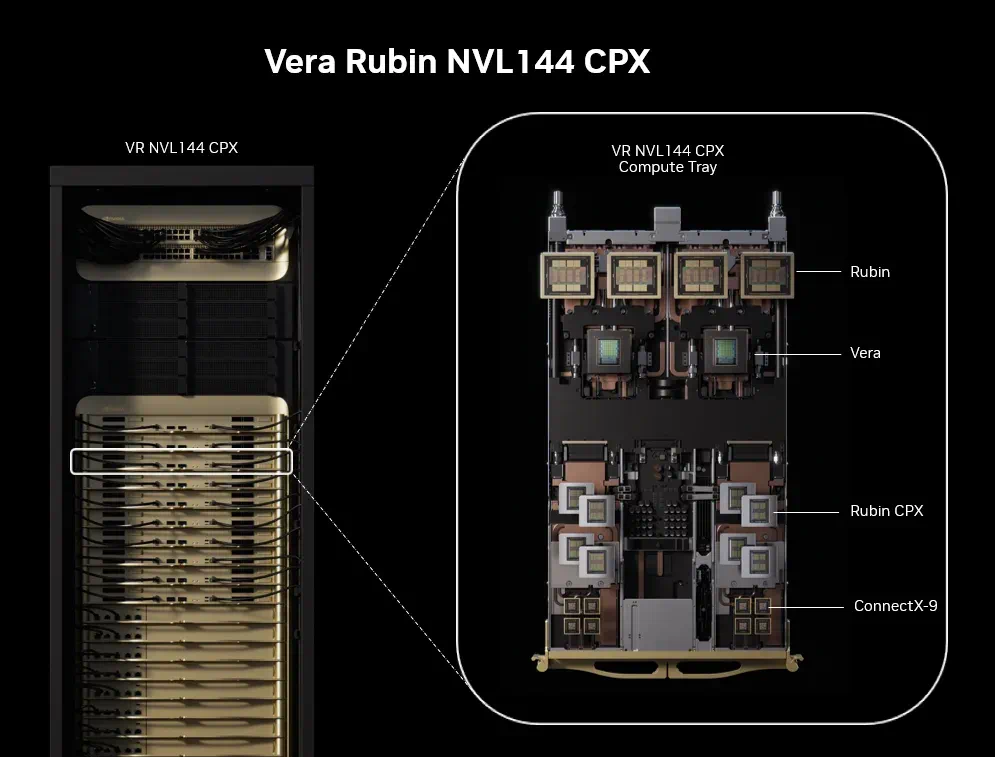

2. Rubin CPX GPU与Vera Rubin平台:硬件革新的核心

Rubin CPX并非单一GPU,而是英伟达Vera Rubin NVL144 CPX平台的核心组件,与NVIDIA Vera CPU、Rubin GPU协同工作,形成完整的AI推理基础设施。该平台单机架即可提供8 exaflops的AI算力(NVFP4精度),是上一代GB300 NVL72系统的7.5倍,同时配备100TB高速内存和1.7 PB/s内存带宽,相当于每秒钟可传输约425部4K电影的数据量。

值得注意的是,英伟达为现有Vera Rubin NVL144用户提供了平滑升级方案——通过更换Rubin CPX专用计算托盘,无需重构整个机架即可接入新技术,这一设计显著降低了企业的部署成本。

Tips:什么是“计算托盘”?

计算托盘是模块化服务器设计的核心组件,集成了GPU、CPU、内存和散热系统。用户可通过更换托盘快速升级硬件,避免整机更换的高成本,这也是英伟达在数据中心领域“硬件即服务”理念的体现。

3. 技术参数解析:从算力到内存的全面跃升

作为平台核心,Rubin CPX GPU本身的硬件参数同样亮眼。它采用全新单片架构(区别于Blackwell架构的双die设计),集成30 petaflops NVFP4精度算力和128GB GDDR7内存,专为AI推理任务优化。以下是其核心参数与上一代系统的对比:

| 参数 | Rubin CPX GPU | GB300 NVL72 系统 | 性能提升 |

|---|---|---|---|

| 架构 | Rubin单片架构 | Blackwell架构 | 新一代 |

| 单GPU算力(NVFP4) | 30 petaflops | — | — |

| 单GPU内存 | 128GB GDDR7 | — | — |

| 平台AI算力(NVFP4) | 8 exaflops | 1.07 exaflops | 7.5倍 |

| 平台高速内存 | 100TB | — | — |

| 平台内存带宽 | 1.7 PB/s | — | — |

| 注意力处理速度 | 3倍提升(对比GB300) | 1倍(基准值) | 3倍 |

其中,NVFP4精度和单片设计是两大关键。NVFP4是英伟达专为推理开发的4-bit浮点格式,在保持模型精度损失可控的前提下,将计算效率提升近2倍;而单片设计则通过优化芯片良率降低成本,并减少多die互联带来的延迟,让长序列注意力机制处理速度提升3倍——这正是长上下文推理的核心性能指标。

4. 解耦式推理架构:让AI“思考”与“表达”更高效

Rubin CPX的突破不仅在于硬件参数,更在于对AI推理流程的重构。传统大模型推理分为两个阶段:上下文处理(输入海量数据并生成首个Token,计算密集型)和内容生成(逐Token输出结果,内存带宽密集型)。过去,这两个阶段共享硬件资源,导致“计算资源闲置时内存带宽不足,内存带宽够用时计算资源浪费”的矛盾。

Rubin CPX通过SMART框架实现全栈解耦设计,将两个阶段的资源调度彻底分离:

- 上下文处理阶段:调用高吞吐量计算单元,快速摄入数百万Token的输入数据,完成模型前向传播和KV缓存构建;

- 内容生成阶段:切换至高带宽内存通道,通过NVLink高速互连逐Token输出结果,减少内存访问延迟。

这种架构配合开源低延迟推理框架NVIDIA Dynamo,在MLPerf Inference v5.0测试中,Rubin CPX平台在长上下文语言模型任务中刷新了吞吐量纪录,同时将延迟降低40%。

Tips:什么是KV缓存?

KV缓存(Key-Value Cache)是LLM推理中的关键技术,用于存储输入序列中每个Token的Key和Value向量,避免重复计算。长上下文推理中,KV缓存会占用大量内存,Rubin CPX的高带宽内存和优化的缓存传输机制,正是解决这一问题的核心。

5. 行业声音:开发者与创作者的新工具

Rubin CPX的发布迅速引发行业关注。代码编辑器Cursor的CEO Michael Truell直言:“过去AI只能理解单个文件,现在借助Rubin CPX,我们能让AI一次性‘阅读’整个代码库(数百万行代码),实现跨文件重构和架构级建议,这将彻底改变软件开发的协作方式。”

视频生成平台Runway的CEO Cristóbal Valenzuela则聚焦内容创作:“当前AI生成视频的最大痛点是‘健忘’——前10秒出现的角色,后10秒可能完全变样。Rubin CPX的百万级上下文支持,让长视频的角色一致性和情节连贯性成为可能,电影级AI创作不再是空想。”

分析师普遍认为,Rubin CPX的定位精准击中了AI产业的“甜蜜点”——随着GPT-4、Claude 3.5等模型的上下文窗口突破百万Token,硬件基础设施已成为制约应用落地的最后瓶颈,而Rubin CPX正是为此而来。

6. 应用场景展望:软件开发、视频生成与科学研究的变革

除了行业领袖的期待,Rubin CPX的长上下文能力将在多个领域带来具体变革:

6.1 软件开发:从“片段理解”到“全局掌控”

传统AI编程助手受限于上下文长度,只能分析单个函数或文件。借助Rubin CPX,AI可理解整个项目的代码结构、依赖关系和设计模式,实现:

- 跨文件复杂bug修复(如定位某个API变更对所有调用模块的影响);

- 架构级重构建议(根据业务需求优化代码分层和数据流);

- 自动化文档生成(基于完整代码库生成系统设计文档和接口说明)。

6.2 视频生成:从“短视频”到“长叙事”

当前AI视频生成工具多聚焦1分钟内的短视频,长视频常出现角色穿帮、场景跳变等问题。Rubin CPX的百万级上下文支持将实现:

- 两小时以上电影级长视频生成,保持角色、场景、风格的全程一致;

- 精细化情节控制(如根据开头的“主角在咖啡馆”指令,确保结尾仍回归同一咖啡馆场景);

- 实时交互生成(用户可中途修改剧情走向,AI动态调整后续内容)。

6.3 科学研究:从“局部数据”到“全局规律”

在科学计算领域,Rubin CPX可让模型一次性分析超长序列数据:

- 基因组学:处理完整人类基因组(约30亿碱基对),发现罕见病相关的复杂基因关联;

- 材料科学:模拟数百万原子的分子动力学过程,加速高温超导材料或新型电池电极的研发;

- 气候研究:整合近百年全球气象数据,提升极端天气预测模型的准确性。

7. 未来挑战

尽管前景广阔,Rubin CPX仍需跨越从“发布”到“普及”的鸿沟。首先是上市时间——英伟达计划2026年底正式出货,意味着开发者至少要等待1年才能体验;其次是成本——单机架8 exaflops算力的平台价格预计高达千万美元级别,初期可能仅云厂商(如AWS、Azure)和大型科技公司负担得起;最后是软件生态——NVFP4精度需要PyTorch、TensorFlow等框架支持,模型训练时也需针对性优化,否则难以发挥硬件性能。

不过,正如英伟达CEO黄仁勋在发布会上所言:“AI的进步永远由‘算力突破’和‘想象力边界’共同驱动。Rubin CPX不是终点,而是让开发者重新定义‘可能’的起点。”

评论