AI芯片[9]

确定性执行:挑战冯诺依曼的计算架构新范式

传统冯诺依曼架构在AI推理、实时数据分析等场景面临能耗高、延迟波动大等瓶颈,确定性执行架构通过硬件级精确调度重构计算逻辑,以统一高效、低能耗、可预测性能突破限制,为企业级AI、工业控制等场景提供新路径。

OpenAI Stargate项目投资500亿美元:350亿专攻AI芯片,打造111吉瓦超级算力中心

OpenAI代号“Stargate”的超级数据中心项目,计划投资500亿美元打造1GW全球顶级算力,其中350亿专项用于AI芯片采购,占比达70%,凸显AI基础设施“烧钱”本质。该项目推动全球算力竞赛升级,2030年全球AI基建投资或破1.1万亿美元,算力成科技竞争力核心,行业正迎来芯片采购与自研的战略分化。

高通骁龙X2 Elite登场:18核Oryon CPU与80 TOPS AI算力重塑笔记本未来

高通新一代旗舰ARM架构笔记本处理器骁龙X2 Elite发布,搭载18核Oryon CPU(主频5.0GHz)及80 TOPS AI算力NPU,深度优化Copilot+ PC生态,AI缓存分区提速40%,兼顾性能与能效,重新定义笔记本性能、续航与智能交互体验。

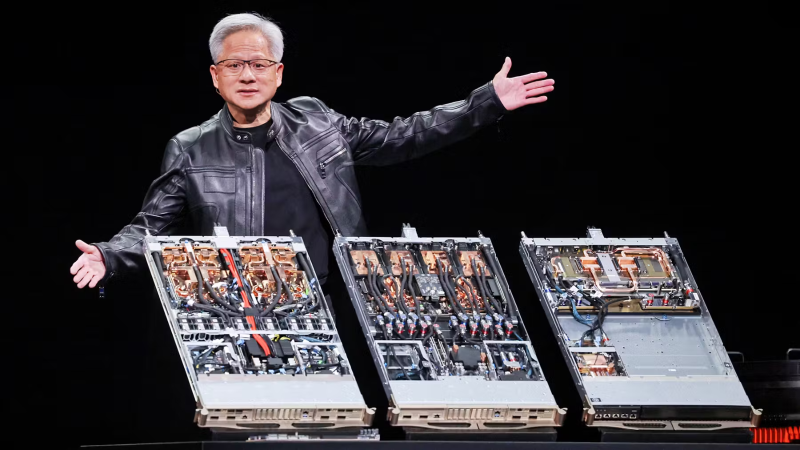

OpenAI与英伟达洽谈AI芯片租赁合作 探索算力资源新获取模式

AI行业算力获取方式正迎变革,OpenAI与英伟达正探讨芯片租赁合作,拟告别传统采购转向按需租赁。此举旨在缓解算力需求激增下的成本压力——传统模式硬件投入高、资源利用率不足60%,而租赁可将重资本支出转为轻运营支出,提升资源利用率至85%以上,还能降低中小企业AI研发门槛,推动算力服务化与行业民主化落地。

Databricks AI负责人Naveen Rao离职创业 瞄准AI计算成本瓶颈

Databricks前AI负责人Naveen Rao离职创业,新公司聚焦AI算力成本优化,获Databricks战略投资。当前AI算力成本成行业瓶颈,推理成本占比超60%且持续增长,其将通过硬件架构创新破局。作为连续创业者,Rao过往项目曾推动AI训练部署成本下降,新方向或加速AI技术普及。

xAI/OpenAI竞逐自研芯片:台积电3nm工艺2026量产,AI算力自主竞赛升温

xAI自研AI推理芯片X1曝光,采用台积电3nm工艺,计划2026年第三季度量产,首批产量30万块,旨在解决算力瓶颈,支撑五年内实现5000万英伟达H100等效算力目标。当前自研芯片已成AI巨头标配,谷歌TPU、Meta MTIA、OpenAI XPU等竞相布局,算力自主化竞赛加剧。X1与OpenAI XPU均瞄准2026年量产,却分野于“完全自研”与“半自研”路线,技术与人才争夺白热化。台积电凭借3nm代工超90%市占率成关键变量,其产能分配直接影响巨头算力野心。此外,特斯拉AI5/AI6芯片与X1形成战略协同,共同推进马斯克生态算力布局。

AWS携手Anthropic押注Trainium2 争夺生成式AI算力市场份额

2025年生成式AI算力竞赛中,AWS正通过与Anthropic深度合作及自研Trainium2芯片实现战略破局。面对Azure(35%份额)、谷歌云(28%份额)的挤压,AWS以“芯片+伙伴”组合拳反击:联合Anthropic落地“规模化法则”,后者依托协同优化实现收入从2023年1亿冲刺2025年50亿;Trainium2芯片单卡160 TFLOPS算力,通过300W低功耗、60kW高密度机柜设计,使AI训练TCO降低25%-30%,Claude 3模型训练成本降40%。双方软硬件协同设计(定制指令集、数据中心适配)成行业模板,推动Top 10 AI实验室加速采用“定制芯片+专用软件栈”策略,重塑全球AI算力格局。

滑铁卢大学与Intel突破脉冲神经网络:类脑算法与神经拟态硬件开启计算革命

脉冲神经网络(SNNs)作为模拟人脑脉冲放电机制的新兴技术,正引领AI能效革命。与传统人工神经网络(ANNs)不同,SNNs通过事件驱动计算实现超低功耗,在神经拟态硬件支持下迎来突破:Intel Loihi 2芯片能效比GPU提升300倍,已赋能奔驰车载感知(延迟降82%)、松下工业质检(5000帧/秒)等场景。滑铁卢大学团队算法创新更让SNNs性能跃升,动态控制误差比GRU低37%,功耗仅为ANN加速器1/8;其构建的250万神经元Spaun模型,可复现大脑认知功能,为类脑研究提供关键工具。当前SNNs在低延迟、高能效领域落地加速,未来随着硬件量产与算法成熟,有望重塑边缘计算、脑机接口等AI应用格局。

谷歌TPU入驻第三方云数据中心挑战英伟达霸权

谷歌TPU首次计划入驻第三方云数据中心,打破自2016年发布以来仅在Google Cloud流通的惯例,已与AWS、微软Azure等主流云厂商洽谈合作,首阶段瞄准医疗、金融等算力敏感行业,直接挑战英伟达AI芯片霸权。此举旨在扩大市场覆盖、争夺AI生态主导权,其TPU v5e芯片在相同性能下功耗比H100低40%,能效优势显著。不过,TPU需克服技术适配(依赖JAX/TensorFlow软件栈、硬件基础设施兼容)与生态壁垒(英伟达CUDA生态深厚)。当前AI芯片竞争已进入硬件算力、软件易用性、部署灵活性“三维战争”,谷歌开放TPU或推动行业向多元生态发展,成AI芯片格局分水岭。