英伟达[13]

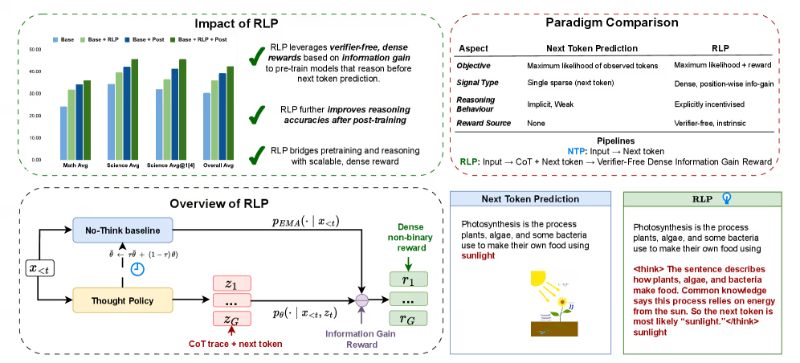

英伟达RLP技术重塑大模型预训练:让AI在预训练阶段“先思考后预测”,推理能力显著提升

英伟达推出的RLP(强化学习预训练)技术,革新AI大模型推理能力培养范式。传统模型依赖后训练微调,存在效率低、易"灾难性遗忘"问题,而RLP在预训练阶段嵌入强化学习,通过"生成思考-增强预测-奖励反馈"闭环,让模型学会"先思考后预测"。实验显示,小模型推理能力提升17%,中模型达35%,且降低人工标注成本,金融、法律等场景多步决策错误率直降30%,实现预训练与后训练效果叠加。

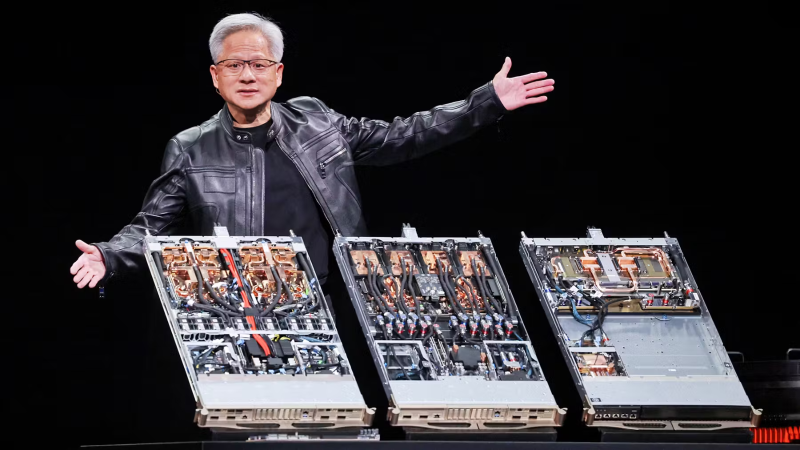

OpenAI与英伟达洽谈AI芯片租赁合作 探索算力资源新获取模式

AI行业算力获取方式正迎变革,OpenAI与英伟达正探讨芯片租赁合作,拟告别传统采购转向按需租赁。此举旨在缓解算力需求激增下的成本压力——传统模式硬件投入高、资源利用率不足60%,而租赁可将重资本支出转为轻运营支出,提升资源利用率至85%以上,还能降低中小企业AI研发门槛,推动算力服务化与行业民主化落地。

OpenAI与NVIDIA达成百亿级战略合作 共建10GW AI基础设施

2025年9月22日,OpenAI与NVIDIA宣布战略合作,计划共建10吉瓦(GW)算力超级系统,NVIDIA分阶段投资1000亿美元,系行业最大规模算力部署,标志AI基础设施竞赛进入ExaScale级新阶段。双方十年技术协同,从DGX-1到ChatGPT算力支撑,首期1GW 2026年落地Vera Rubin平台,基于Blackwell Ultra GPU与液冷集群,推动超级智能时代跃迁。

NVIDIA加速AI生态布局:NIM、Omniverse与HPC驱动多领域创新

NVIDIA以NIM、Omniverse、HPC为核心构建技术生态,重塑AI推理、工业数字孪生、科学计算全链条。NIM简化模型部署,Omniverse凭OpenUSD推动工业仿真,HPC加速气候模拟等,已在营销、科研、制造等多行业落地,提升效率并降低成本。

英伟达50亿美元入股英特尔 联手打造CPU+GPU融合芯片重塑计算格局

2024年9月,英伟达斥资50亿美元入股英特尔并达成深度战略合作,共同开发融合CPU与GPU的下一代计算芯片,聚焦数据中心与个人计算领域。依托NVLink-C2C芯粒互联技术实现硬件原生一体设计,合作推动英特尔股价暴涨22.77%,有望重塑全球计算产业格局,开启半导体“融合时代”。

英伟达斥资超9亿美元招揽Enfabrica CEO并授权其AI互联技术

英伟达斥资超9亿美元“人才收购”Enfabrica核心团队及AI互联技术,以解决十万级GPU集群协同瓶颈。该模式成科技巨头补位技术缺口新趋势,助力英伟达从GPU供应商向AI基础设施全栈方案商转型,强化“计算+连接”系统级优势,推动AI竞争进入“算力+互联”深度融合新阶段。

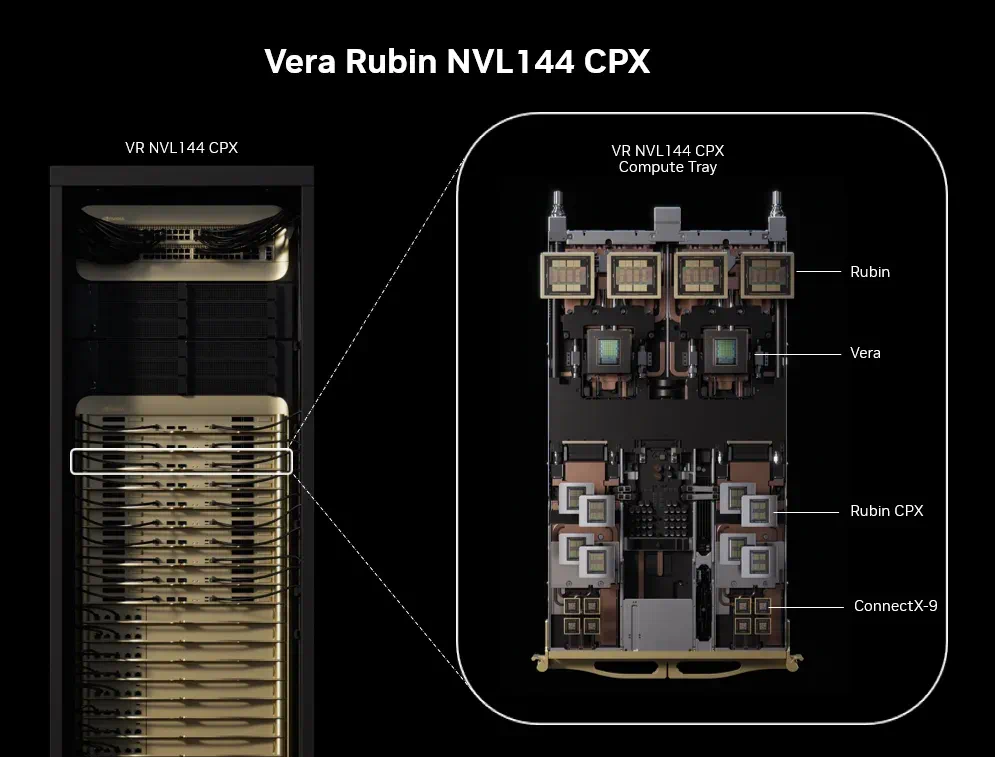

英伟达推出NVIDIA Rubin CPX GPU:首款百万级token上下文AI推理芯片,性能与内存双重突破

英伟达发布新一代AI推理GPU Rubin CPX,专为超大上下文处理与生成式视频打造,配备128GB GDDR7内存、30 PFLOPS算力(NVFP4精度优化),集成视频编解码单元,投资回报率达50倍,2026年底上市,重塑AI推理效率与应用边界。

英伟达发布突破性Rubin CPX GPU:重塑百万级长上下文AI推理

英伟达推出专为百万级长上下文推理设计的Rubin CPX GPU,采用解耦式架构与长序列处理单元(LSPU),实现3倍注意力机制处理速度,端到端延迟降低40%、能耗下降55%。其128GB GDDR7内存与动态资源分配技术,赋能代码生成、法律研究、长视频分析等场景,重塑AI推理基础设施,预计2026年底上市。

xAI/OpenAI竞逐自研芯片:台积电3nm工艺2026量产,AI算力自主竞赛升温

xAI自研AI推理芯片X1曝光,采用台积电3nm工艺,计划2026年第三季度量产,首批产量30万块,旨在解决算力瓶颈,支撑五年内实现5000万英伟达H100等效算力目标。当前自研芯片已成AI巨头标配,谷歌TPU、Meta MTIA、OpenAI XPU等竞相布局,算力自主化竞赛加剧。X1与OpenAI XPU均瞄准2026年量产,却分野于“完全自研”与“半自研”路线,技术与人才争夺白热化。台积电凭借3nm代工超90%市占率成关键变量,其产能分配直接影响巨头算力野心。此外,特斯拉AI5/AI6芯片与X1形成战略协同,共同推进马斯克生态算力布局。

英伟达UDR:策略驱动破解智能体痛点,重构AI研究范式

英伟达通用深度研究系统(UDR)针对金融、医药等领域深度研究智能体(DRT)的模型绑定、策略固化、资源浪费痛点,以“策略驱动”重构AI研究范式。通过解耦LLM与研究逻辑,支持自然语言定制策略、多模型自由接入(如GPT-4、Llama 3协同)及资源精细化控制(GPU占用缩短70%),实现研究效率提升60%、LLM调用成本降低40%。其“两层分离”架构(用户界面层+代理逻辑层)与策略编译、模型适配器等技术,已在金融并购分析(风险评估效率跃升)、医药研发(FDA报告分析时间缩至3小时)等场景验证价值。虽处原型阶段,但其灵活适配高价值研究需求,正推动AI智能体从工具绑定迈向策略自由。