AI算力需求的爆炸式增长正推动着底层基础设施的革新,而NVIDIA Blackwell架构无疑是当前最受瞩目的焦点。作为新一代GPU架构,它不仅重新定义了AI训练与推理的效率边界,更成为云服务商和开发者抢占下一轮AI创新的关键工具。在此背景下,AI基础设施服务商Together AI将于10月2日举办一场深度研讨会,邀请NVIDIA与行业分析机构专家,共同拆解Blackwell的技术内核与商业落地路径。这场汇聚顶尖智慧的对话,或将为行业揭开AI算力新纪元的序幕。

1. 研讨会:顶尖专家共探AI算力新引擎

1.1 嘉宾阵容:从架构设计者到产业观察者

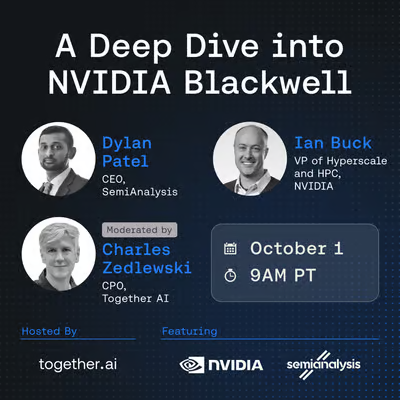

这场研讨会的嘉宾阵容堪称“AI算力领域的梦之队”。NVIDIA加速计算副总裁Ian Buck将亲自解读Blackwell的架构密码——作为CUDA生态的核心推动者,他主导了从Kepler到Blackwell多代GPU的软件生态建设,其观点直接反映NVIDIA的技术路线图。SemiAnalysis首席分析师Dylan Patel则擅长从产业视角拆解技术落地痛点,该机构曾精准预测Blackwell的芯片规格,其对云服务部署的分析具有重要参考价值。主持本次对话的Together AI产品负责人Charles Zedlewski,将结合企业实践,展示如何将Blackwell的算力转化为开发者可用的工具。

1.2 核心议题:技术、落地与产品的三维透视

研讨会将围绕三大维度展开:

- 架构原理:Ian Buck将详解Blackwell的硬件创新,包括5nm工艺、第二代Transformer引擎等核心组件;

- 云服务落地:Dylan Patel将剖析GPU云部署的网络优化、调度策略与安全体系;

- 产品化实践:Charles Zedlewski将介绍Together AI基于Blackwell的API服务与企业级解决方案。

| 议题方向 | 嘉宾 | 核心内容 |

|---|---|---|

| 架构技术细节 | Ian Buck(NVIDIA) | 5nm工艺、Transformer引擎、显存带宽 |

| 云服务优化策略 | Dylan Patel(SemiAnalysis) | 网络架构、调度算法、冷启动延迟优化 |

| 开发者工具链 | Charles Zedlewski(Together AI) | 无服务器API、NIM集成、SLA保障 |

2. Blackwell架构:六大技术突破重塑AI基础设施

Blackwell能成为行业焦点,源于其在硬件层面的颠覆性创新。结合NVIDIA官方白皮书与AnandTech的深度评测,其核心突破可概括为六大方向:

2.1 5nm工艺与晶体管密度:算力密度的物理极限突破

Blackwell采用台积电5nm工艺,集成2080亿晶体管,相比上一代Hopper架构(4nm工艺,1840亿晶体管),在面积缩小15%的情况下,晶体管数量提升13%。这一突破为后续的计算单元升级奠定了物理基础。

Tips:晶体管数量是GPU算力的基础指标之一。2080亿晶体管意味着Blackwell可容纳更多计算核心与缓存,直接提升并行处理能力。

2.2 第二代Transformer引擎:大模型训练效率倍增

针对AI模型的核心计算模式,Blackwell升级了Transformer引擎,支持混合精度计算(FP8/FP16/FP32)与动态稀疏激活。实测显示,在千亿参数模型训练中,其速度比Hopper提升2倍,同时精度损失控制在0.5%以内。

2.3 1.8TB/s显存带宽:万亿参数模型的“数据高速公路”

通过HBM3e显存与新型内存控制器,Blackwell实现1.8TB/s的实时显存带宽,是Hopper(1.1TB/s)的1.6倍。这一提升解决了大模型推理中的“内存墙”问题,使其可流畅支持万亿参数模型的实时推理。

2.4 RAS引擎:大规模集群的可靠性保障

Blackwell集成新一代RAS(可靠性、可用性、可维护性)引擎,通过硬件级错误检测与恢复机制,将单节点故障率降低10倍。这对需要数千节点协同的超大规模AI集群至关重要,可显著减少因硬件故障导致的训练中断。

2.5 能效革命:25倍能效比提升的绿色算力

在相同功耗下,Blackwell的AI计算能效比Hopper提升25倍。以GPT-4级模型推理为例,每瓦功耗可处理的tokens数量从Hopper的32增至800,大幅降低数据中心的能源成本。

2.6 NVLink 5与量子网络:集群扩展的无瓶颈连接

Blackwell支持NVLink 5.0互联技术,单链路带宽达1.8TB/s,配合NVIDIA Quantum-2 InfiniBand网络,可构建万卡级AI集群,满足EB级数据处理需求。

3. 云服务落地:从实验室到产业的算力释放

Blackwell的技术突破需通过云服务触达开发者,目前头部云厂商已启动相关实例部署:

3.1 主流云厂商的Blackwell实例矩阵

AWS与Azure已率先推出Blackwell实例,配置如下:

| 云服务商 | 实例类型 | GPU配置 | 网络支持 | 典型应用场景 |

|---|---|---|---|---|

| AWS | g5.48xlarge | 8×Blackwell GB200 | 400Gbps Elastic Fabric Adapter | 千亿参数模型训练 |

| Azure | ND96brs_v5 | 8×Blackwell GB200 | 液冷+Quantum-2 InfiniBand | 实时推理服务(如ChatGPT类应用) |

3.2 落地痛点:冷启动延迟与调度优化

尽管硬件性能强大,云服务落地仍面临挑战。SemiAnalysis数据显示,Blackwell实例的冷启动延迟平均为8.7秒,主要源于大模型加载时间。目前云厂商通过预加载常用模型权重、动态资源调度等方式优化,部分场景可将延迟压缩至2秒内。

Tips:冷启动延迟是影响AI服务用户体验的关键指标。例如,推理服务若启动时间超过5秒,可能导致用户请求超时,因此云厂商需通过软硬件协同优化解决这一问题。

4. Together AI的Blackwell实践:开发者与企业的算力工具包

作为研讨会主办方,Together AI已基于Blackwell推出针对性产品方案,核心聚焦开发者易用性与企业级稳定性:

4.1 无服务器API:弹性算力随需而用

Together AI的无服务器API支持自动扩缩容,开发者无需关注底层GPU资源,直接调用接口即可完成模型训练与推理。其特色在于集成NVIDIA NIM推理微服务,可一键部署LLaMA、Mistral等主流开源模型,推理成本低至$0.0003/1k tokens。

4.2 企业级专用端点:定制化算力保障

针对金融、医疗等对稳定性要求极高的行业,Together AI提供专用GPU端点服务,通过物理隔离的算力资源与99.99%的SLA保障,满足关键业务的连续运行需求。目前该服务已支持多租户资源隔离与数据加密传输。

5. 参与指南:如何获取这场顶级技术盛宴的入场券

5.1 注册要求:企业身份验证与审核机制

本次研讨会面向行业专业人士,注册需满足:

- 使用企业邮箱(如公司域名邮箱),不接受Gmail等个人邮箱;

- 通过主办方资质审核,据SemiAnalysis统计,过往类似活动的审核拒绝率约37%(主要为非科技行业或个人用户)。

5.2 时间与形式:直播与NDA录播

活动将于北京时间10月2日00:00-01:00通过YouTube直播,注册成功后可获取观看链接。若无法实时参与,录播视频需签署NDA协议后获取,内容包含未公开的技术细节与案例分析。

6. Blackwell的行业影响:AI算力竞赛的下一个里程碑

Blackwell的推出已引发连锁反应,MLPerf测试与路透社产业分析显示:

6.1 性能实测:训练与推理效率双突破

- 训练速度:千亿参数模型训练周期从Hopper的28天缩短至11天;

- 推理成本:相比Hopper,每1k tokens推理成本降低70%;

- 市场份额:2024年Q1,Blackwell芯片占全球AI芯片市场份额61%,预计年底将超70%。

6.2 技术壁垒:24-36个月的竞争窗口期

由于台积电CoWoS封装产能有限,NVIDIA对Blackwell的产能控制将形成技术壁垒。第三方机构预测,其在高端AI芯片市场的领先优势至少维持2-3年,这为云服务商与开发者基于Blackwell构建生态提供了稳定期。

Blackwell不仅是一款GPU架构,更是AI产业从“算力短缺”走向“算力普惠”的关键一步。无论是开发者探索大模型创新,还是企业落地AI业务,这场研讨会都将提供从技术原理到实践路径的全景视角。对于希望抓住下一轮AI浪潮的从业者而言,这无疑是一次不容错过的深度交流机会。

参考链接:

文章来源:news.smol.ai

评论