在人工智能领域,模型参数量的“军备竞赛”似乎已成常态——从百亿到千亿参数,大模型不断刷新性能上限,但也带来算力消耗高、部署门槛高的问题。近日,AI初创公司Perceptron发布的感知语言模型Isaac 0.1,却以20亿(2B)参数的“轻量级”姿态,宣称在核心感知任务上超越参数量级更大的模型,并采用开放权重策略,为物理AI的效率突破提供了新思路。

1. 模型定位:感知语言模型,连接数字与物理世界的“新大脑”

1.1 从“读文字”到“懂世界”:感知语言模型的核心价值

传统大语言模型(LLM)擅长处理文本信息,但在理解物理世界的视觉、空间等感知数据时往往需要依赖独立的视觉编码器(如CLIP)作为“外挂”,架构复杂且效率有限。而Isaac 0.1定位的“感知语言模型”(Perceptive Language Model),则是将语言理解与感知能力深度融合的新型AI模型。

写作Tips:感知语言模型的关键在于“统一理解”——它能直接处理图像、视频等物理世界感知输入,无需多模型拼接,从而实现从文本指令到物理交互的端到端能力。这种特性使其成为具身智能(如机器人通过语言指令操作环境)、智能监控、自动驾驶等领域的核心技术支撑。

Perceptron官方资料显示,Isaac 0.1的设计初衷正是“让AI不仅能‘读文字’,更能‘看懂世界’”,这一定位使其区别于纯文本LLM,成为连接数字指令与物理行动的“新大脑”。

2. Isaac 0.1的技术突破:2B参数如何挑战大模型?

2.1 统一编码框架:甩掉“视觉外挂”的效率密码

Isaac 0.1的核心技术创新在于采用“统一编码框架”。传统多模态模型通常需要独立的文本编码器和视觉编码器,再通过跨模态注意力机制融合信息,这不仅增加计算量,还可能导致模态间信息损失。而Isaac 0.1通过架构优化,将文本与视觉感知输入直接编码为统一表征,省去了独立视觉编码器的“外挂”环节,从底层提升了效率。

2.2 参数优化:精准“发力”核心感知任务

尽管仅20亿参数(远小于主流10B-70B参数的大型模型),Isaac 0.1通过训练目标聚焦“核心感知任务”(如视觉问答、图像描述、空间推理),而非追求全场景通用能力,实现了参数效率的最大化。Perceptron在官方博客中提到,模型训练数据专门强化了物理世界场景的感知样本,使其在机器人交互、环境理解等任务上的表现尤为突出。

3. 开放权重策略:为何是AI生态的“催化剂”?

3.1 从闭源到开放:透明度与创新的平衡

Isaac 0.1采用开放权重(Open Weights)策略,模型权重已在GitHub和Hugging Face等平台公开,许可证采用宽松的MIT协议,允许商业使用和二次开发。这与多数闭源大模型(如GPT-4V、Claude 3)形成鲜明对比。

写作Tips:开放权重模型与开源软件类似,允许开发者访问底层权重参数,进行微调、优化或集成到自有系统中。这种模式的优势在于:提升模型透明度(可审计偏见与安全问题)、降低研究门槛(学术界无需依赖API调用)、加速应用落地(企业可基于开源权重定制行业解决方案)。

3.2 社区反响:开发者与研究者的积极响应

Hugging Face社区数据显示,Isaac 0.1发布后48小时内,已有超千次模型下载,开发者开始尝试将其微调用于机器人控制、智能家居交互等场景。AI领域KOL如Dr. Jim Fan在Twitter评论称:“小参数+开放权重的组合,可能比闭源大模型更能推动物理AI的落地——毕竟不是所有场景都需要千亿参数的‘全能选手’,但几乎所有场景都需要‘高效可用’的模型。”

4. 性能对比与行业争议:“超越大模型”是否可信?

4.1 官方数据:感知任务上的“以小胜大”

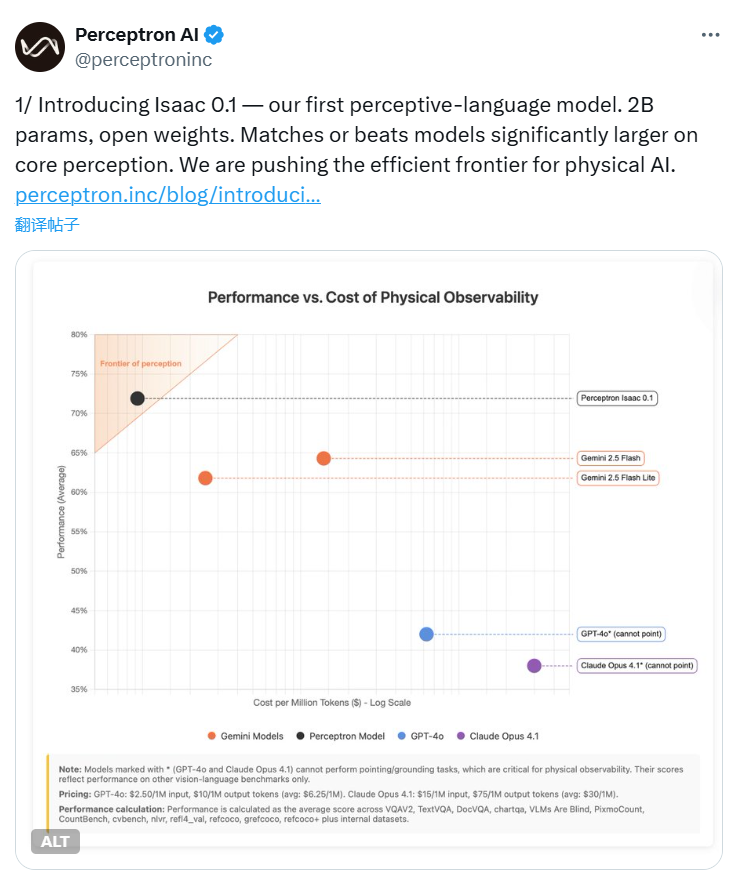

Perceptron官方提供的对比数据显示,在视觉问答(VQAv2)、图像描述(COCO Captioning)等感知任务中,Isaac 0.1的准确率与70亿参数闭源模型相当,甚至在空间推理任务上超越部分100亿参数级模型。其与同类开源模型的对比也显示出优势:

| 模型名称 | 参数规模 | 权重开放性 | 视觉问答准确率(VQAv2) | 图像描述BLEU分数 |

|---|---|---|---|---|

| Isaac 0.1 | 2B | 开放(MIT) | 78.3% | 34.2 |

| LLaVA-1.5(开源) | 7B | 开放(LLaMA许可证) | 77.5% | 33.8 |

| Gemini Nano-2(闭源) | ~3.2B | 闭源 | 76.9% | 32.5 |

数据来源:Perceptron官方技术报告及Hugging Face社区初步测试

4.2 审慎声音:需更多第三方验证

尽管官方数据亮眼,社区也存在审慎观点。AI研究者@AI_Researcher在Reddit讨论中指出:“目前对比的任务可能经过‘精心挑选’,Isaac 0.1在通用语言理解(如MMLU基准)上的表现尚未公开,且训练数据的规模与构成透明度不足,需要等待更全面的第三方评测(如MMMU多模态基准)来验证其真实能力。”

5. 物理AI的未来:效率与落地,谁是关键?

5.1 物理AI的核心诉求:不止于“强”,更要“能用”

“物理AI”指应用于物理世界的AI系统,其核心诉求并非单纯的性能指标,而是效率(低算力消耗)、延迟(实时响应)、可靠性(边缘设备部署)。Isaac 0.1的2B参数规模使其可在消费级GPU甚至边缘设备上运行,这对机器人、智能家居等场景至关重要——例如,家庭服务机器人需要在本地实时处理视觉输入并响应指令,无法依赖云端大模型的高延迟调用。

5.2 从小模型到生态:开放与协作的趋势

Isaac 0.1的发布反映了AI行业的一个新趋势:从“参数军备竞赛”转向“效率与开放并重”。随着更多开发者基于开放权重进行优化(如针对特定硬件的量化压缩、垂直行业数据微调),物理AI可能形成“小模型+开源生态”的创新范式,加速从实验室到产业落地的进程。

6. 总结:感知语言模型的“效率革命”才刚刚开始

Isaac 0.1的推出,以2B参数、开放权重、感知语言模型三大标签,为AI行业提供了一个重要启示:在物理世界应用中,“够用且高效”可能比“全能但笨重”更有价值。尽管其“超越大模型”的宣称仍需更多验证,但开放生态与参数效率的结合,已为物理AI的落地打开了新空间。随着社区参与度提升,我们或许将看到更多“小而美”的AI模型,在机器人、自动化、智能家居等领域释放真正的产业价值。

参考链接

评论