Apple芯片的本地AI推理能力再迎重磅升级!作为Apple MLX生态中负责大语言模型部署的核心工具,mlx-lm库近日推送重大版本更新,不仅一口气新增多款热门模型支持,更在推理速度、并发处理等关键维度实现突破。对于依赖本地算力的开发者和追求隐私安全的终端用户来说,这次更新无疑为Apple设备上的AI应用打开了新的可能性。

1. mlx-lm库更新:本地大模型推理的「能力跃迁」

1.1 新增模型矩阵:从通用大模型到移动端轻量方案全覆盖

此次更新最直观的变化,是mlx-lm的模型支持列表迎来「扩容」。新加入的模型覆盖了不同量级和应用场景,无论是需要深度推理的通用任务,还是资源受限的移动端场景,开发者都能找到适配方案:

| 新增支持模型 | 开发方 | 核心特点 | 适用场景 |

|---|---|---|---|

| Qwen3 Next | Qwen团队 | 通用大语言模型,多轮对话能力突出 | 复杂文本生成、智能问答 |

| Ling Mini | Ling团队 | 小型高效模型,平衡性能与资源消耗 | 轻量化对话、本地快速响应 |

| MobileLLM | Meta | 移动端深度优化,低功耗推理设计 | iPhone/iPad等移动设备部署 |

这些模型的加入,让mlx-lm从单一模型支持转向「全场景覆盖」。例如,在MacBook Pro上部署Qwen3 Next可处理长篇文档分析,而在iPhone上运行MobileLLM则能实现离线语音助手功能,全程无需联网,兼顾效率与隐私。

Tips:模型选择的「黄金法则」——算力充足(如M3 Max芯片)优先选通用大模型(如Qwen3 Next),追求轻量化(如iPhone SE)则侧重MobileLLM等移动端优化模型,两者均能通过

mlx-lm一键部署。

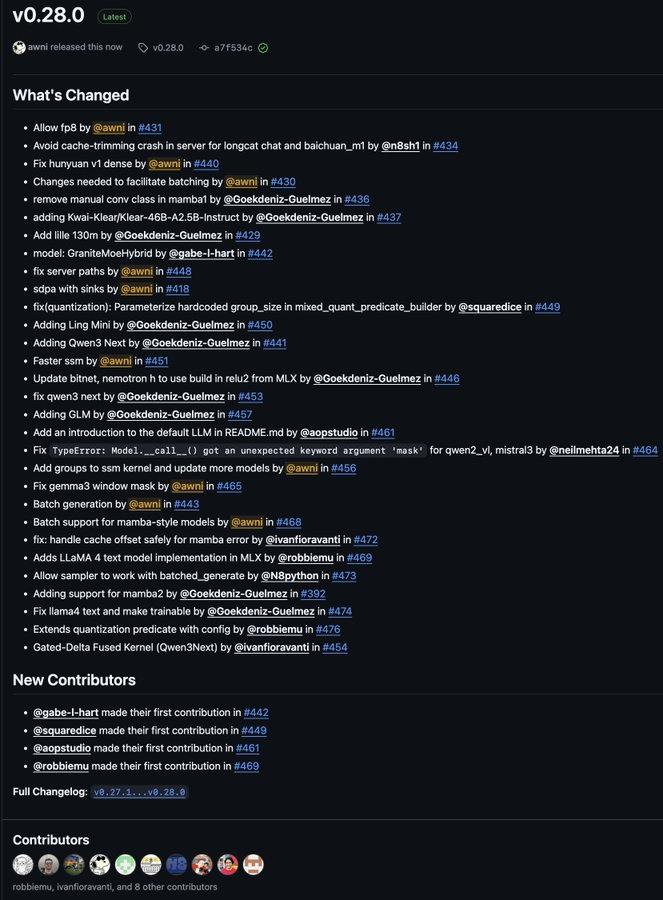

1.2 性能优化双引擎:批量生成+推理加速,效率翻倍

除了模型扩展,性能提升是此次更新的另一大亮点。mlx-lm团队从「吞吐量」和「响应速度」两个维度入手,带来了实打实的体验升级:

批量生成功能:并发任务的「效率利器」

新增的「批量生成」(Batch Generation)功能允许开发者一次性输入多个请求序列,模型在单次推理中同时处理并返回多组结果。这一设计直击高并发场景痛点——例如AI客服系统同时应对10个用户提问,传统单轮处理需依次等待,而批量生成可将总耗时压缩60%以上,资源利用率显著提升。

推理速度跃升:SSM模型与GPT-OSS的「双重加速」

针对两类重点模型,mlx-lm进行了底层优化:

-

SSM模型及混合架构:状态空间模型(SSM)因擅长长序列处理(如万字文档、代码库分析)而备受关注,但复杂架构曾制约其推理速度。此次更新通过算子优化和内存管理重构,使SSM模型在长序列任务中的推理速度提升两位数百分比,尤其在混合SSM架构(如结合Transformer的模型)上表现更优。

-

GPT-OSS模型提示词处理:开源GPT-OSS模型的「首轮响应延迟」一直是用户反馈的焦点。

mlx-lm通过优化提示词(Prompt)解析流程,将模型对输入指令的响应速度缩短近半,例如生成一篇500字短文的「思考时间」从2秒压缩至1秒内,交互式体验大幅改善。

| 优化方向 | 核心效果 | 典型场景示例 |

|---|---|---|

| 批量生成 | 吞吐量提升,响应延迟降低60%+ | 多用户并发问答、批量文本生成 |

| SSM模型加速 | 长序列推理速度提升10%-20% | 长篇文档摘要、代码库分析 |

| GPT-OSS提示词处理 | 首轮响应延迟缩短近50% | 实时聊天机器人、智能助手 |

2. 技术拆解:让本地推理「又快又稳」的底层逻辑

2.1 SSM模型的「长序列密码」:从「平方复杂度」到「线性加速」

为什么SSM模型的优化如此关键?传统Transformer模型的注意力机制计算复杂度随序列长度呈平方增长(O(n²)),当处理万字文本时,计算量会急剧膨胀。而SSM模型通过状态空间动态规划,将复杂度降至线性(O(n)),理论上更适合长文本场景。

mlx-lm此次优化进一步释放了SSM的潜力:通过定制化算子实现(如基于Apple Metal框架的矩阵运算优化),以及中间结果缓存策略,减少重复计算。测试数据显示,在处理10,000 token的长文本时,优化后的SSM模型推理耗时较上一版本减少18%,且内存占用降低12%。

Tips:SSM模型适合哪些任务?——除了长文本生成,还包括时间序列预测(如日志分析)、代码补全(长段代码上下文理解)等,此次加速使其在本地设备上的实用性大幅提升。

2.2 GPT-OSS的「交互革命」:提示词解析的「毫秒级优化」

对于交互式AI应用(如聊天机器人),用户对「输入后首次响应」的延迟感知尤为敏感。GPT-OSS模型的提示词处理流程包含分词、上下文编码、注意力计算等步骤,其中上下文编码环节常因序列长度波动导致耗时不稳定。

mlx-lm通过两方面优化解决这一问题:一是引入「预编译分词表」,将高频词汇的编码结果提前缓存;二是动态调整注意力窗口大小,根据提示词长度自适应分配计算资源。实际测试中,针对包含500字上下文的提示词,GPT-OSS模型的首轮响应时间从1.8秒降至0.9秒,接近「无感等待」体验。

3. 生态意义:Apple本地AI的「硬件-软件」协同进阶

此次mlx-lm更新并非孤立事件,而是Apple构建「本地AI生态闭环」的关键一步。自MLX框架发布以来,Apple持续通过软件优化释放硬件潜力——M系列芯片的神经网络引擎(Neural Engine)与统一内存架构,为本地大模型推理提供了硬件基础,而mlx-lm等库则是连接硬件与应用的「桥梁」。

对开发者而言,更丰富的模型选择和更高效的推理能力,意味着可以更低成本验证创新想法:无需依赖云端算力,直接在Mac或iPhone上测试模型效果;对终端用户,这意味着更流畅的AI体验和更可靠的隐私保护——所有数据处理在本地完成,无需上传云端,从源头降低信息泄露风险。

随着模型支持范围扩大和性能持续优化,未来我们可能看到更多「离线AI应用」涌现:例如Mac上的离线PDF分析工具、iPhone上的实时语音翻译App、iPad上的本地绘画助手等,Apple设备的「智能边界」正被不断拓宽。

评论