本地部署[9]

Mojo实现Apple Silicon GPU初步支持 Mac端AI开发迎新阵地

Mojo语言最新夜间版本实现Apple Silicon GPU初步支持,为Mac端AI开发者带来本地GPU加速新可能。此前Mac用户受硬件门槛与工具链限制,依赖云端或外接显卡,现可本地完成算法编写调试,降低开发成本、提升效率。支持M1-M4芯片,需macOS 15、Xcode 16及Metal API,已能运行矩阵运算等基础场景,未来将完善PyTorch互操作等核心功能。

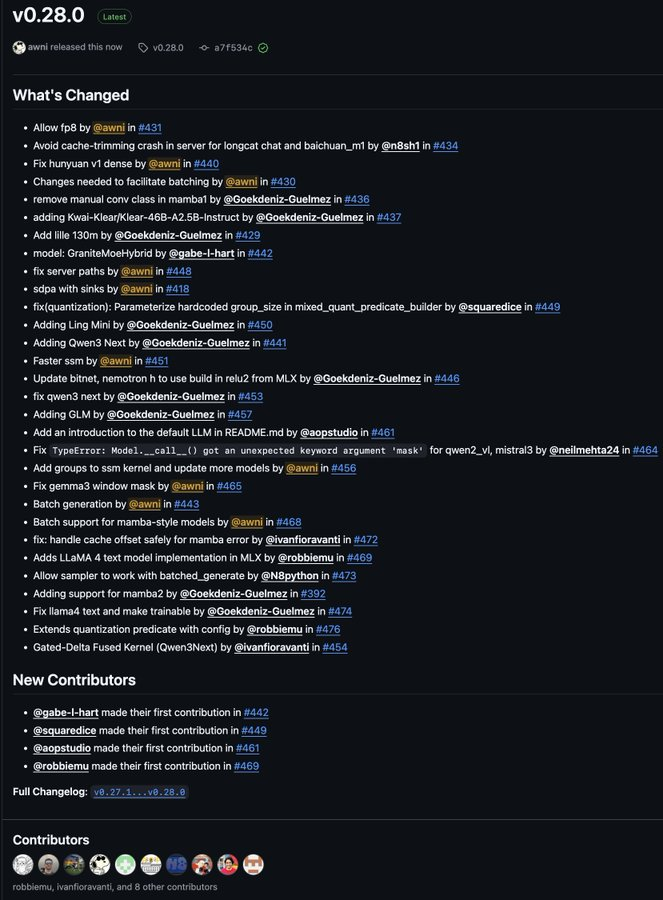

mlx-lm库重大更新:Apple芯片本地AI推理新增多款模型,性能显著提升

Apple芯片本地AI推理能力迎重磅升级,mlx-lm库重大更新!新增Qwen3 Next、MobileLLM等热门模型,覆盖通用大模型及移动端轻量场景,推理速度与并发处理效率显著提升,支持批量生成及SSM/GPT-OSS加速。助力开发者依托本地算力部署,提升终端用户隐私安全,为Apple设备AI应用开辟新可能。

智跃Agent一体机:AI私人助理开启CEO管理新纪元

2025年AI硬件新品智跃Agent一体机,定位CEO专属AI助理,6.8万元本地化部署软硬件一体化设备。主动整合企业信息生成决策报告,穿透层级信息直达,实时监控项目动态,保障数据安全,助力管理者提升决策效率,开箱即用适配非技术背景管理层。

Project Fluently发布FluentlyQwen3-4B:引入“思考模式”的通用大模型

FluentlyQwen3-4B是基于Qwen3-4B-Base微调的通用大模型,核心亮点为可切换“思考模式”,能显式展示推理步骤提升可解释性,适配数学、编码等复杂任务。上下文扩展至131K tokens,兼容SGLang/vLLM等框架,支持多量化版本低门槛部署,在教育、开发等场景表现亮眼。

PaddlePaddle发布OCR堆栈重大更新 聚焦解决VLM文本定位与幻觉难题

通用VLM处理密集文档OCR时存定位不准与内容幻觉痛点,阻碍金融医疗等行业落地。PaddlePaddle PP-OCRv4以分治策略优化,通过PP-YOLOE检测、SVTR识别模块,密集文本定位F1-score达0.95,幻觉率降75%,大幅提升行业数据处理准确性。

Unsloth框架:重新定义开源LLM微调的效率与稳定性标准

Unsloth作为新兴开源LLM微调框架,凭借内存优化技术与主流模型缺陷修复能力,重新定义本地化训练标准:在A100显卡上实现Llama-3 8B模型训练速度提升3.2倍、显存占用减少80%,且零精度损失。其通过OpenAI Triton内核重构计算模块,结合分层梯度检查点与4-bit量化技术,将Llama-3.1-8B微调显存需求从48GB降至12GB,使消费级RTX 4090也能胜任专业卡任务。团队深度参与开源生态,已修复Qwen3 128K上下文崩溃、Phi-3位置编码偏移等主流模型缺陷,相关补丁被llama.cpp、Microsoft等项目采纳。支持微调与RLHF一体化流程,广泛应用于法律科技(如LexNex合同分析)、电商客服(如ShopBot回复优化)等领域,经社区验证内存优化效果显著,有效降低中小团队AI个性化成本门槛。

Perplexity推出政府专属AI服务:安全零门槛重塑公共治理效率

Perplexity推出美国政府专属AI服务“Perplexity for Government”,聚焦联邦、州、地方政府及教育组织,以“默认安全+零合同门槛”重塑政府AI接入模式。服务默认开启FedRAMP Moderate合规认证,数据全程美国境内AWS政府云处理,保障数据主权;零合同即开即用,50人以下小机构可免费使用基础功能,降低接入成本;支持GPT-4、Llama 3等多模型切换,适配政策分析、信息检索等多元场景。已应用于CDC疫情数据实时分析、EPA政策文件摘要生成等场景,响应白宫AI行政命令安全要求,推动政府AI从试点迈向规模化落地,为公共治理智能化提供高效、安全新方案。

阿里通义千问Qwen3-30B MoE量化版发布:消费级硬件实现本地部署

近日,Hugging Face社区正式推出Qwen3-30B-A3B-Instruct-2507-MXFP4_MOE模型,这一基于阿里通义千问Qwen3架构的量化版本,以17.1GB的文件体积和30.5B参数量,在保持高性能的同时将大型MoE模型的硬件门槛拉至新低点。

微软BitNet.cpp开源:CPU成百亿大模型新引擎,提速6倍降能耗82%

微软开源的BitNet.cpp框架,基于创新1-bit量化技术,让普通CPU成为百亿大模型新引擎,彻底摆脱GPU依赖。该技术通过二进制权重压缩,减少约90%内存占用,精度仅降2.3%。实测显示,消费级CPU运行100B模型推理速度达28.6 tokens/秒,较传统GPU方案提升6.17倍,能耗降低82.2%,内存节省81.6%。框架支持Llama3、Falcon3等主流模型,可广泛应用于边缘计算、个人AI助手、企业降本等场景。其开源特性推动AI民主化,加速“硬件去依赖”趋势,显著降低大模型推理门槛。