当我们还在惊叹于GPT-4 Turbo支持12.8万token的“超长文本处理能力”时,Google的最新研究已经将这一数字推向了新的高度——1000万token。近日,Google DeepMind发布的ATLAS模型,用一种名为“可训练记忆模块”的全新架构,彻底绕开了传统Transformer的注意力机制瓶颈,让AI首次实现了对百万级token文本的高效理解与推理。这不仅是技术参数的突破,更可能重塑长上下文AI的未来发展路径。

1. ATLAS:突破长文本处理的算力枷锁

1.1 从“望文兴叹”到“百万token自由”:长上下文的AI痛点

在AI大模型席卷各行各业的今天,“处理更长文本”始终是一个棘手难题。传统Transformer架构依赖的自注意力机制,需要让文本中的每个token与其他所有token交互,这种“全局连线”的方式虽然保证了理解的关联性,却带来了计算量的“平方级爆炸”——当文本长度从1万token增加到100万token时,计算量会从1亿次飙升到1万亿次,即便是顶级GPU也难以承受。这也是为什么目前主流大模型的上下文窗口大多停留在几万到几十万token,面对几百页的法律卷宗、上千页的医学研究文献,或是一整个代码仓库时,往往只能“管中窥豹”。

1.2 核心创新:用“记忆模块”重构AI的信息处理方式

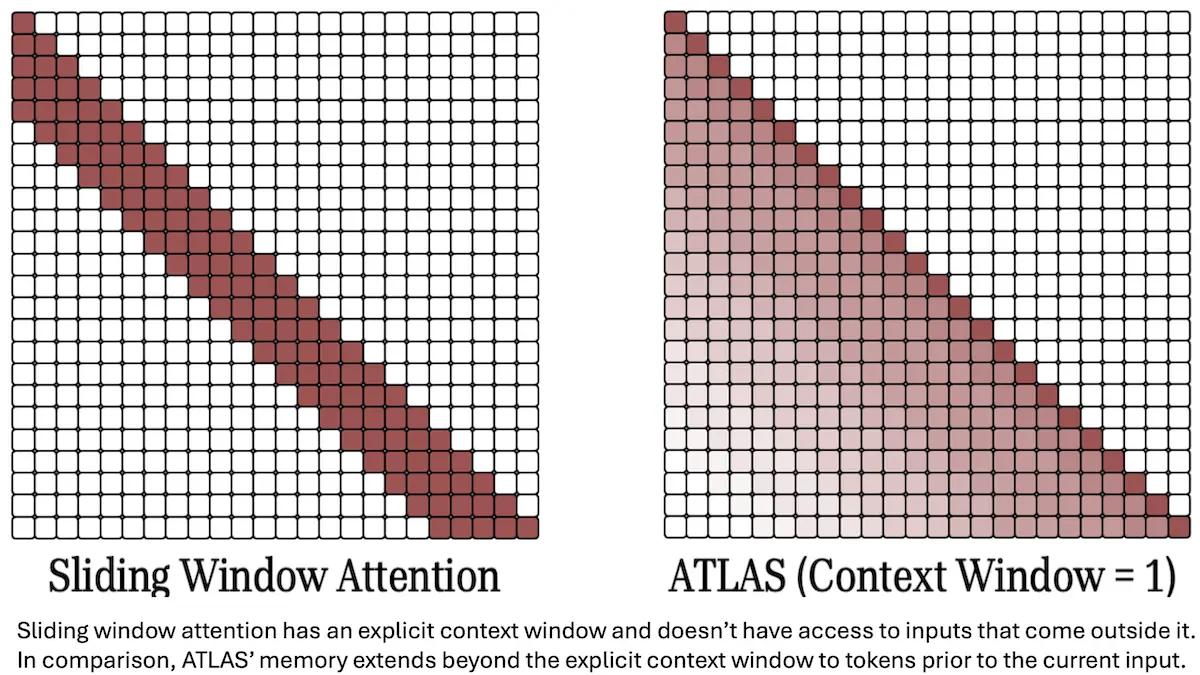

ATLAS(全称Augmented Transformer Library with Augmented Memory and Pointer Structures)的出现,正是为了打破这一枷锁。它没有选择“硬堆算力”来硬撑更长文本,而是从架构层面进行革新——用可训练的记忆模块(Memory Module)完全替代了传统Transformer中的自注意力层。简单来说,传统模型需要“记住所有细节”,而ATLAS学会了“只记重点”:它会主动筛选文本中的关键信息(如核心事实、实体关系、事件逻辑),压缩成结构化的“记忆向量”存入外部记忆库;在需要推理或生成内容时,再像查数据库一样从记忆库中精准调取相关信息。这种“存储-检索”模式,让模型终于摆脱了对“全局交互”的依赖。

2. 技术深剖:记忆模块如何“以简驭繁”?

2.1 传统注意力机制的“阿喀琉斯之踵”

要理解ATLAS的革命性,首先需要明确传统注意力机制的局限。假设一段文本有n个token,自注意力机制需要计算n×n个“注意力分数”(即每个token对其他所有token的关联强度),这意味着计算复杂度为O(n²)。当n=1000时,计算量约为100万次;当n=100万时,计算量会暴增至1e12次——这不仅需要海量内存存储中间结果,更会让推理时间变得不可接受。

Tip:为什么“平方级增长”对长文本是致命的?以常见的GPU内存为例,假设每个注意力分数占用4字节,100万token的文本需要存储4×(1e6)²=4e12字节(约3.64TB),这远超当前顶级GPU的显存容量(通常为80-100GB)。因此,注意力机制本质上是“为短文本设计”的架构,长文本处理是其天然短板。

2.2 记忆模块的“智能管家”模式:写入与读取的协作

ATLAS的记忆模块通过“写入-读取”两个核心步骤,将计算复杂度从O(n²)降至接近O(n):

- 写入(Write):模型处理输入文本时,会通过一个“筛选器”识别关键信息(如“某法律条款规定合同有效期为3年”“某医学研究显示药物A的副作用发生率为5%”),并将这些信息压缩成固定维度的“记忆向量”,存入一个可动态扩展的记忆库。这个过程类似人类做笔记时“提炼核心观点”,而非逐字抄写。

- 读取(Read):当模型需要回答问题或生成内容时(如“该合同的有效期是多久?”),会根据当前查询从记忆库中检索最相关的记忆向量(如之前存入的“3年”条款),并将其作为上下文输入到后续计算中。检索时采用类似“语义相似度匹配”的方式,确保只调取有用信息。

通过这种设计,模型不再需要处理原始文本的全部token,只需操作固定大小的记忆向量(记忆库规模通常远小于原始文本长度),从而实现了对百万级token的高效处理。

3. 性能验证:1000万token下的“精准答题”

3.1 BABILong基准:从整本书中“大海捞针”

ATLAS的实力在专门设计的长上下文基准测试中得到了验证。其中最具代表性的是BABILong——一个要求模型在1000万token(相当于一部长篇小说)的文本中,精准定位并回答事实性问题的测试集。例如,测试可能给出一整本书的内容,然后提问“主角在第15章提到的童年好友叫什么名字?”。在这一极端场景下,ATLAS的准确率达到了80%,而同期的Titans、Transformer++等模型准确率均低于80%。这意味着,ATLAS已经具备在“信息海洋”中快速“捞针”的能力。

3.2 FineWeb数据集:13亿参数模型的“训练养料”

为了支撑这一能力,Google团队在FineWeb数据集上训练了13亿参数的ATLAS模型。FineWeb是Google构建的大规模网页文本数据集,以“高质量、低噪声”著称——它通过严格的去重和过滤,剔除了重复内容和低价值信息,保留了学术论文、权威报道、专业文档等优质文本。值得注意的是,ATLAS的训练采用了“主体冻结、记忆微调”的策略:模型主体参数保持不变,仅更新记忆模块的参数。这种方式不仅大幅降低了训练成本,还让模型能快速适应不同领域的长文本任务(如法律、医疗),为实际落地提供了便利。

4. 应用图景:从“短文本专家”到“长文本智者”的跨越

4.1 行业落地:法律、医疗与代码的“超长助手”

ATLAS的1000万token处理能力,正在打开此前AI无法触及的应用场景:

- 法律领域:律师可将几百页的合同、判例库批量输入ATLAS,模型能快速定位冲突条款、检索相关判例,甚至生成合规性分析报告,将原本需要数天的人工审查缩短至几小时。

- 医疗领域:研究人员可上传上千篇医学论文,ATLAS能自动梳理不同研究的结论冲突、提取关键数据(如药物疗效、副作用发生率),辅助快速撰写综述或设计新实验。

- 代码开发:开发者可导入整个大型代码仓库(如包含数万行代码的开源项目),ATLAS能理解模块间的调用关系、识别潜在bug,甚至基于历史代码逻辑生成新功能的实现方案。

- 多轮对话:客服、教育等场景中,ATLAS能维持数月甚至数年的对话历史上下文,避免“失忆”导致的回答矛盾(如记住用户半年前提到的过敏史、学习进度)。

4.2 潜在挑战:记忆的“准确性”与“检索效率”

尽管前景广阔,社区也提出了需要解决的挑战:

- 记忆准确性:如果记忆模块错误地“提炼”或“存储”了信息(如将“副作用发生率5%”记成“50%”),会直接导致推理错误,甚至引发严重后果(如医疗建议失误)。

- 检索精准度:当记忆库规模过大(如存储了数万条记忆向量),如何确保检索时不遗漏关键信息?目前ATLAS的检索机制依赖语义相似度,但复杂逻辑关联(如“因果关系”“反事实推理”)可能难以捕捉。

- 多模态扩展:当前ATLAS仅支持文本输入,未来如何将图像、视频、音频等信息转化为“记忆向量”存入模块,实现跨模态长上下文理解,仍是重要方向。

5. 行业反响与未来方向

5.1 业界评价:“平衡数据驱动与高效推理的典范”

ATLAS的发布迅速引发了AI社区的热议。DeepLearning.AI在官方解读中指出,其最大价值在于“在数据规模与推理效率之间找到了新的平衡点”——传统长上下文模型往往通过“扩大注意力窗口”(如增加token上限)硬堆性能,而ATLAS通过架构创新从根本上降低了算力需求。Hacker News等技术社区的讨论则认为,这种“存储-计算分离”的思路可能成为下一代大模型的设计范式,尤其为边缘设备部署长上下文AI提供了可能。

5.2 下一步:更大模型与多模态记忆的融合

Google研究团队表示,未来将从两个方向推进ATLAS:一是训练更大规模的模型(如百亿、千亿参数),验证记忆模块在复杂任务上的潜力;二是探索多模态记忆机制,让模型能存储和检索图像中的视觉特征、视频中的动态事件,实现“文本+图像+视频”的超长多模态上下文处理。若这些目标实现,ATLAS可能不仅是“长文本智者”,更会成为“跨模态记忆大师”。

评论