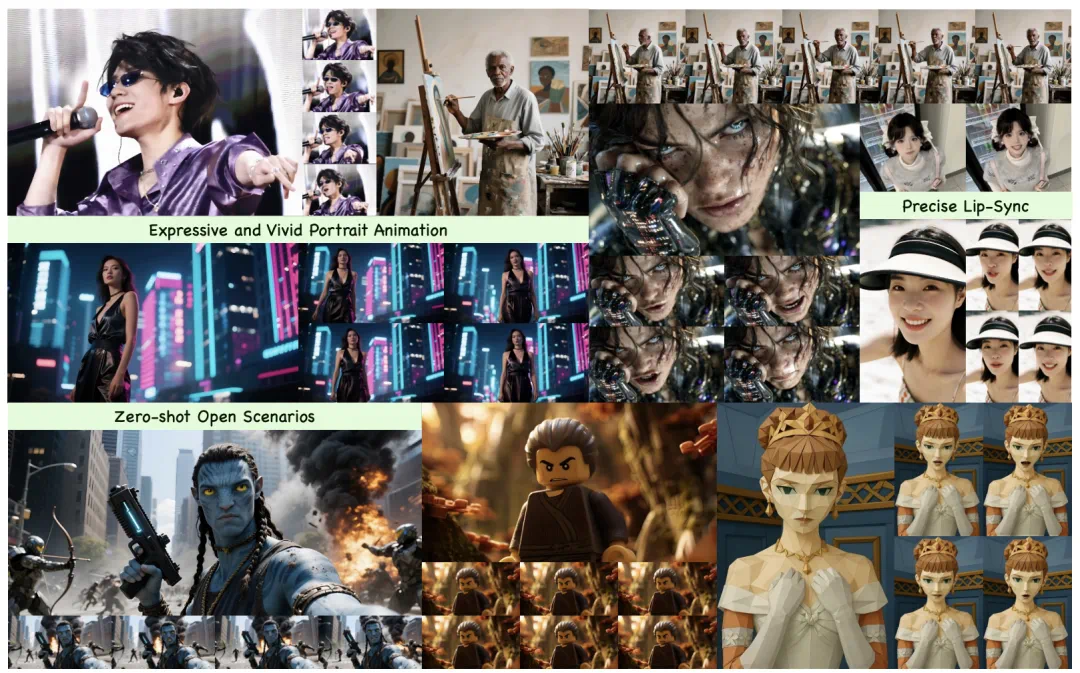

数字人技术正在经历从“形似”到“神似”的关键跨越。近日,快手可灵团队公开了其AI数字人核心技术“Kling-Avatar”,不仅发布了详细技术报告,还同步开启了产品公测。这项技术最引人注目的突破在于:数字人不再局限于机械的口型同步,而是真正实现了包含表情、肢体、情绪在内的“全身自然表演”。从虚拟主播到影视动画,这一技术或将重新定义内容创作的边界。

1. 从“对口型”到“演剧情”:数字人技术的代际突破

传统数字人技术的痛点十分明显:即便口型与音频同步精准,也往往显得僵硬——缺乏自然的表情变化,肢体动作与场景脱节,更无法根据内容传递细腻情绪。例如,当音频是欢快的歌曲时,数字人可能只是机械张嘴,而不会配合出现微笑、挥手等符合情绪的动作;当文本提示“悲伤地讲述故事”时,面部表情也难以呈现对应的低落感。

Kling-Avatar的出现正是为了解决这一问题。通过多模态大语言模型(MLLM)的深度驱动,它能让数字人“读懂”内容、“理解”情绪,并据此生成连贯的全身表演。无论是演讲时的手势强调、对话时的眼神互动,还是唱歌时的肢体律动,数字人都能自然呈现,甚至支持分钟级长视频的稳定输出,镜头切换和动作衔接流畅度堪比真人表演。

可灵数字人产品界面已开放公测,用户可通过文本、音频、图像输入生成“会表演”的数字人视频。体验地址:https://app.klingai.com/cn/ai-human/image/new

2. Kling-Avatar的核心突破:用“导演思维”驱动数字人表演

要让数字人“会表演”,关键在于让它具备“理解内容”和“统筹全局”的能力。Kling-Avatar的技术核心,正是模拟了人类导演的工作逻辑——通过“多模态导演模块”(MLLM Director)整合输入信息,再分阶段生成完整表演。

2.1 多模态输入:让数字人“看懂、听懂、读懂”

“MLLM导演”模块如同数字人的“大脑”,能同时处理三种关键信号:

- 音频:不仅识别语音内容,还能解析语调中的情感(如欢快、悲伤、愤怒);

- 图像:分析参考人像的面部特征、姿态,以及场景环境(如室内、户外、特写镜头);

- 文本提示:精准捕捉用户对动作(如“挥手”“点头”)、镜头(如“推近”“全景”)、情绪(如“惊讶”“温柔”)的具体要求。

通过对这三种信号的综合理解,系统能构建出一份结构化的“剧情描述”,明确表演的节奏(如快节奏说唱、慢节奏叙述)、风格(如正式演讲、轻松对话)和关键节点(如强调某个词时的手势)。

Tips:什么是多模态大语言模型(MLLM)?

MLLM是能同时处理文本、图像、音频等多种模态信息的AI模型。相比传统仅处理文本的语言模型,它更接近人类“多感官理解世界”的方式,因此能让数字人更精准地“理解”表演需求。

2.2 蓝图视频:为表演画好“全局剧本”

基于“剧情描述”,“MLLM导演”会先生成一段“蓝图视频”。这段视频并非最终成品,而是一份“全局大纲”——它确保数字人的整体动作风格、情绪走向、镜头逻辑在长时间内保持一致。例如,若文本提示“从微笑开场,逐渐转为严肃表情”,蓝图视频会明确这一情绪转变的时间节点和过渡方式,避免后续生成中出现表情跳变。

3. 两阶段生成:从“大纲”到“成片”的无缝衔接

有了“蓝图视频”这一全局框架,Kling-Avatar通过第二阶段的“级联生成”,将蓝图细化为流畅的完整视频。这一过程类似电影拍摄:先确定关键场景(关键帧),再逐一拍摄片段,最后剪辑拼接。

3.1 关键帧挑选:锁定表演的“高光时刻”

系统会从蓝图视频中自动挑选关键帧,标准包括:

- 身份一致性:面部特征、服装纹理与参考图高度匹配;

- 动作多样性:避免重复动作,确保表演丰富;

- 表情清晰度:嘴部、眼部等关键表情区域无模糊。

这些关键帧相当于表演的“锚点”,例如“挥手动作的最高点”“惊讶表情的瞬间”,为后续片段生成提供明确的起止参考。

3.2 子段生成与拼接:解决长视频“断层”难题

传统数字人生成技术在处理长视频时,容易出现动作不连贯、表情跳变(如突然皱眉)等问题。Kling-Avatar通过“子段并行生成”解决这一痛点:以相邻关键帧为起止点,分别生成多个短视频片段(如5秒一段),再将片段无缝拼接。由于每个片段都以关键帧为“边界”,且共享蓝图视频的全局逻辑,最终拼接出的长视频自然流畅,避免了“断层感”。

3.3 音频对齐插帧:让口型与节奏“严丝合缝”

表演的真实感离不开“音画同步”。Kling-Avatar引入了“音频对齐插帧”技术:将音频按音节切分,与视频帧精准匹配;同时,在关键帧之间插入过渡帧,确保嘴型开合、肢体动作与音频节奏(如说唱的快节奏、演讲的停顿)完全同步。即便是“truth”这类发音复杂的单词,或远景镜头中人脸较小时,口型对齐依然精准。

Tips:级联生成的优势是什么?

直接生成分钟级长视频对AI算力和一致性控制要求极高。级联生成通过“先全局、后局部”的策略,既能降低计算压力,又能避免长视频中的细节失真,是当前数字人生成的高效方案。

4. 细节打磨:三大策略保障“自然感”与“可控性”

即便有了框架和流程,数字人表演仍需解决三大核心问题:口型是否精准、文本指令是否有效、身份是否稳定。Kling-Avatar通过针对性优化,给出了答案。

4.1 口型对齐:远近景都“说得清楚”

- 近景优化:自动检测嘴部区域,对模糊帧进行加权去噪,确保唇形细节清晰;

- 远景优化:当人脸在画面中占比小时,扩展视频帧以增强面部特征捕捉,避免口型“糊成一团”。

4.2 文本可控性:让“指令”不被AI“遗忘”

为防止模型过度依赖训练数据而“忽视”用户文本提示(如文本要求“挥手”,却生成了“点头”),团队冻结了文本跨注意力层的参数——这相当于“锁定”了文本与动作的对应关系,确保“文本说什么,数字人做什么”。

4.3 身份一致性:告别“变脸式”表演

数字人最尴尬的问题之一是“身份漂移”:生成过程中突然出现面部纹理模糊、肤色变化等“不像本人”的情况。Kling-Avatar在推理阶段构造“退化负样本”(如故意生成模糊、肤色异常的图像),通过对比负样本与正常样本,抑制身份特征的漂移,让数字人从始至终“长得像自己”。

5. 性能验证:多项指标领先主流竞品

为证明技术实力,可灵团队建立了严格的测评基准:包含375组“参考图-音频-文本提示”样本,覆盖真人/AI生成图像、中/英/日/韩多语言、快慢语速、多样情绪等场景。通过与OmniHuman-1、HeyGen等主流数字人技术对比,Kling-Avatar在多项核心指标上表现突出:

| 评测维度 | Kling-Avatar | OmniHuman-1 | HeyGen |

|---|---|---|---|

| 总体效果 | 领先 | - | 略优 |

| 口型同步 | 领先 | - | 持平 |

| 画面质量 | 领先 | - | 持平 |

| 指令响应 | 领先 | - | 领先 |

| 身份一致性 | 领先 | - | 持平 |

(数据来源:Kling-Avatar技术报告用户偏好测评,采用Good/Same/Bad评分体系)

尤其在“总体效果”和“指令响应”上,Kling-Avatar的优势显著——用户反馈其表演“更像真人”“更懂我想要什么动作”。

6. 开放与落地:从技术到产品的“最后一公里”

目前,基于Kling-Avatar的“会表演”数字人功能已在快手可灵平台(https://app.klingai.com)开启公测,逐步向创作者和开发者开放。用户只需上传参考图、输入音频和文本提示,即可生成数字人表演视频。

此外,团队计划开源测评基准和部分训练数据,推动行业共同进步。这意味着,未来不仅是快手生态,整个虚拟内容创作领域(如虚拟主播、动画制作、广告代言)都可能用上这项技术——数字人或许将从“工具”变为“演员”,真正走进内容创作的核心舞台。

从机械对口型到自然表演,Kling-Avatar的突破不仅是技术的进步,更让我们看到:AI数字人正在从“模仿人类”走向“理解人类”。当虚拟人能真正“读懂”情绪、“演活”故事,内容创作的想象力边界,或许才刚刚被打开。

参考链接

评论