算力[29]

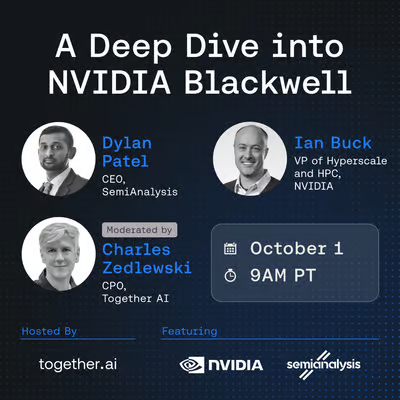

Together AI主办NVIDIA Blackwell架构深度研讨会 专家解析技术突破与应用

AI算力需求激增推动底层革新,NVIDIA Blackwell架构成焦点,其5nm工艺、Transformer引擎等六大突破重塑AI基础设施。Together AI将于10月2日举办研讨会,邀NVIDIA与行业专家拆解技术内核与云服务落地路径,助力开发者抢占AI创新先机。

数据中心能耗危机 科技巨头探索太空数据中心

AI数据中心正面临能耗与水资源双重压力:训练大模型耗电量堪比30万户家庭年用电,数据中心耗水量激增致资源紧张。科技巨头探索太空数据中心构想,利用近地轨道持续太阳能与天然低温环境破解能耗难题,蓝色起源、OpenAI等已布局。地面微型核能、地热方案短期主导减排,太空方案虽面临辐射防护、维护等挑战,长期或成AI可持续发展能源解方。

华为云CloudMatrix384超节点升级:AI Token推理性能超英伟达H20四倍

全球AI算力需求指数级增长下,华为云于HC2025宣布重大升级:CloudMatrix384超节点从384卡扩展至8192卡,Tokens服务性能特定场景超英伟达H20四倍,同步推出EMS弹性内存存储。此举标志中国云计算企业在AI算力基础设施领域系统性能力跃升。

《AI 2030》报告:2030年成AI分水岭,算力千亿级与科学突破重塑多领域

《AI 2030》报告由谷歌DeepMind委托Epoch发布,勾勒2030年AI发展分水岭,聚焦算力、数据、经济回报与科学突破。预测前沿算力集群成本将破千亿美元,2027年公开文本数据或枯竭,合成数据成新引擎;头部企业营收激增支撑投入,能源压力推动数据中心革新。马斯克认可趋势,报告揭示AI从工具向协作者蜕变的机遇与挑战。

英伟达斥资超9亿美元招揽Enfabrica CEO并授权其AI互联技术

英伟达斥资超9亿美元“人才收购”Enfabrica核心团队及AI互联技术,以解决十万级GPU集群协同瓶颈。该模式成科技巨头补位技术缺口新趋势,助力英伟达从GPU供应商向AI基础设施全栈方案商转型,强化“计算+连接”系统级优势,推动AI竞争进入“算力+互联”深度融合新阶段。

Triton团队发布Gluon:专为GPU底层性能调优的新型编程语言

Triton团队发布新型GPU编程语言Gluon,作为Triton生态“性能进阶工具”,共享编译器与开发工具链,通过暴露底层硬件控制参数(如CTA分配、数据布局)填补通用编程与极致性能优化空白。开发者可灵活切换抽象层级,平衡开发效率与算力释放,适用于AI大模型核心算子、HPC等场景,被社区称为“GPU编程的罗塞塔石碑”。

月之暗面开源Checkpoint Engine:Kimi K2模型参数更新突破20秒

月之暗面(Moonshot AI)开源Checkpoint Engine技术,针对大模型强化学习训练参数同步难题,将Kimi K2模型参数更新时间从10分钟压缩至20秒,大幅提升GPU利用率与训练效率,解决大模型训练隐形瓶颈,为行业提供高效工程优化方案。

谷歌MetaX联合发布SpikingBrain:脑启发大模型实现长上下文推理100倍加速,非NVIDIA平台高效运行

AI圈“SpikingBrain技术报告”引发讨论,宣称谷歌与MetaX联合开发脑启发大模型突破长上下文效率瓶颈,然经核查存诸多疑点:论文编号属未来未分配状态、MetaX C550 GPU平台虚构、性能数据与当前技术脱节。其提及的脉冲神经网络(SNN)和线性注意力是真实研究热点,公众可通过核查论文、硬件及数据辨别AI突破性新闻真伪,理性看待行业进展。

美国科技巨头在英投资逾310亿英镑 OpenAI“星门”项目落地伦敦郊外

美国科技巨头集体押注英国,微软、OpenAI、英伟达等投超310亿英镑布局AI算力。OpenAI星门项目落地,部署6万颗英伟达Blackwell芯片;英伟达联合伙伴投110亿建数据中心。英国政府加速审批、降电费吸引投资,助力巩固全球AI枢纽地位,推动主权AI时代算力竞赛升级。

Skypilot研究:网络与存储优化让分布式生成式AI训练提速10倍,打破GPU性能瓶颈惯性思维

生成式AI训练中,网络与存储性能是被低估的隐藏瓶颈。Skypilot团队实验显示,在不更换GPU、不修改代码的情况下,仅优化网络带宽(10Gbps→100Gbps)和存储类型(标准云SSD→本地NVMe),分布式训练速度可提升10倍,打破“GPU决定一切”认知。这一发现凸显数据传输与读取效率的关键作用,Skypilot框架助力简化基础设施优化,为AI训练提速提供新路径。