超长上下文[18]

Project Fluently发布FluentlyQwen3-4B:引入“思考模式”的通用大模型

FluentlyQwen3-4B是基于Qwen3-4B-Base微调的通用大模型,核心亮点为可切换“思考模式”,能显式展示推理步骤提升可解释性,适配数学、编码等复杂任务。上下文扩展至131K tokens,兼容SGLang/vLLM等框架,支持多量化版本低门槛部署,在教育、开发等场景表现亮眼。

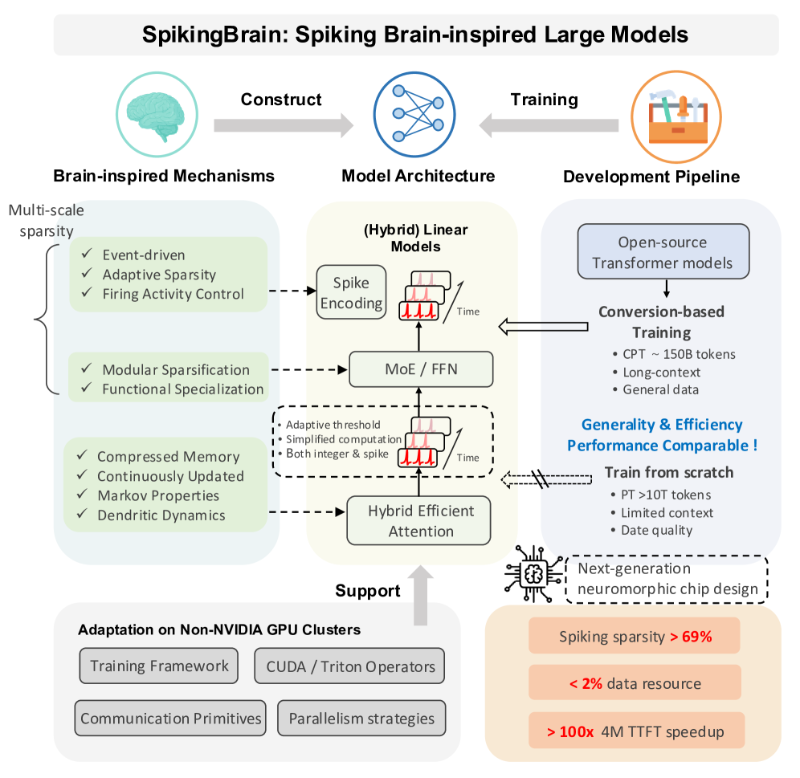

脑启发式大模型SpikingBrain发布:长序列处理提速百倍 能效优化破Transformer瓶颈

中国团队研发的SpikingBrain脑启发大模型,突破LLM长上下文处理瓶颈,通过脑启发脉冲计算、线性注意力机制及动态路由MoE结构,实现百倍推理加速与97.7%能耗降低。支持4M-token超长文本分析,适配法律、医疗及边缘计算场景,依托国产MetaX硬件平台,为非Transformer架构LLM提供自主可控高效方案。

百度ERNIE-4.5-21B-A3B-Thinking登顶HuggingFace文本模型趋势榜

百度ERNIE-4.5-21B-A3B-Thinking登顶HuggingFace全球文本模型趋势榜,总榜位列第三,中国AI技术再获国际认可。该模型采用MoE架构与稀疏激活设计,210亿总参数仅激活30亿,实现轻量高性能。支持128K长上下文(约25万字)及高效工具调用,开源降低应用门槛,推动金融、医疗等复杂场景落地。

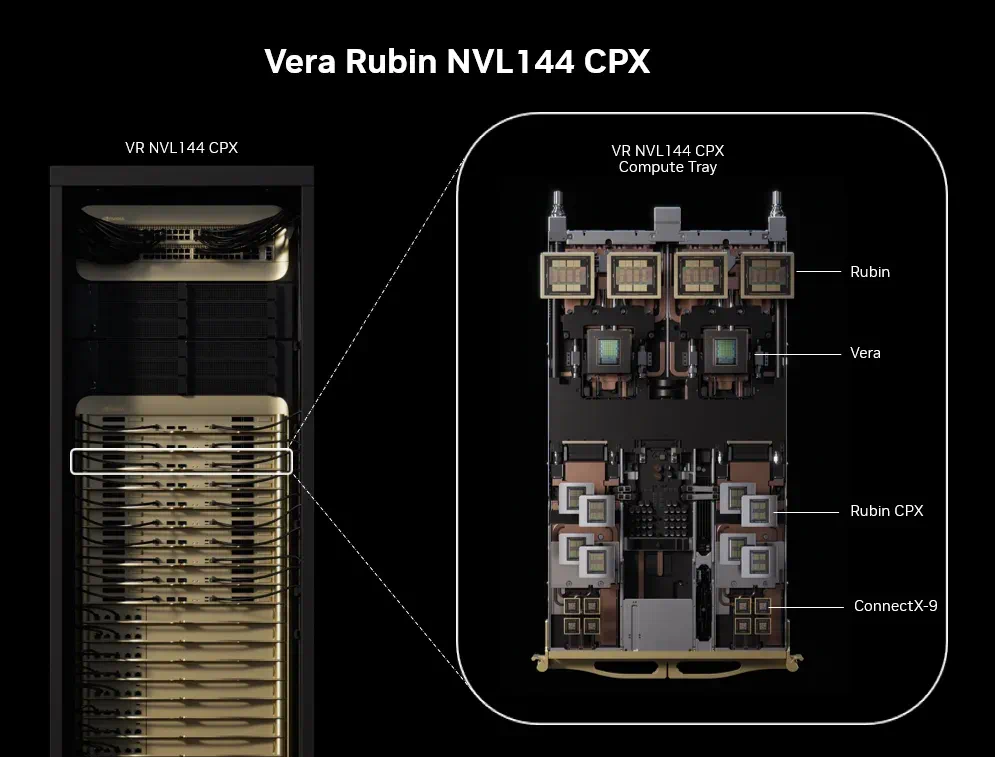

英伟达发布突破性Rubin CPX GPU:重塑百万级长上下文AI推理

英伟达推出专为百万级长上下文推理设计的Rubin CPX GPU,采用解耦式架构与长序列处理单元(LSPU),实现3倍注意力机制处理速度,端到端延迟降低40%、能耗下降55%。其128GB GDDR7内存与动态资源分配技术,赋能代码生成、法律研究、长视频分析等场景,重塑AI推理基础设施,预计2026年底上市。

Google AI Plus印尼首推 新兴市场低价定制启AI普惠

Google推出全新订阅服务“AI Plus”,聚焦新兴市场开启AI普惠化新尝试,首站落地印尼,后续将扩展至印度、泰国、墨西哥等地区。该服务针对新兴市场用户需求定制,印尼月费仅约4.56美元,不足美国同类服务价格的25%,锚定本地中端手机月分期费用降低付费门槛。核心功能涵盖Gemini 2.5 Pro(128K上下文窗口)、本地化AI工具集及Google Workspace深度集成,适配长文档分析、多轮对话等个人与中小微企业场景。免费版每日提供5次Gemini 2.5 Pro试用,引导用户转化。此举通过“低价+实用功能”组合,推动高端AI能力下沉,加速新兴市场数字经济效率提升,开启全球AI普惠化新阶段。

月之暗面Kimi K2 0905升级:智能体能力跃升+256K上下文窗口翻倍

月之暗面Kimi K2 0905版本升级带来两大核心突破:智能体(Agentic)能力跃升与上下文窗口翻倍至256K tokens,参数量稳定1T级别,为开发者与企业提供平滑过渡基础。智能体能力方面,Terminal-Bench Hard复杂编程测试得分从14%升至23%,Tau2-Bench Telecom智能体聊天测试从61%提至73%,背后推理链优化算法通过动态拆解任务、实时调试反馈,使复杂指令错误率降40%。256K上下文窗口(约50万字)依托稀疏注意力与动态缓存技术实现,长文档关键信息召回率达92.3%,可一次性处理2000页司法卷宗(如“三体著作权案”材料)、10万分子式数据库或3年工程运维日志,助力律师分析时间从3天缩至4小时、药物筛选从1周减至2小时。目前企业尽调效率提升3倍,咨询行业已应用,虽存在功耗增18%、数据安全需求等挑战,仍推动AI从“执行指令”向“自主解决问题”进化。

Meta REFRAG框架:四步流程突破LLM长文本处理效率瓶颈,速度提升30倍

LLM在处理长文本时面临计算量平方级增长、响应延迟等效率瓶颈,Meta推出的REFRAG框架通过“智能压缩+选择性处理”创新思路破解难题。其四步流程(压缩、缩短、加速、选择)将输入文本16:1语义浓缩,输入长度缩短16倍,计算量减少至1/256,结合RL策略锁定关键信息,信息保留率达92%。实测显示,REFRAG在16k token场景首个token生成时间加速30倍,单次可处理8倍检索结果,GSM8K推理准确率提升80%,128k上下文节省89%计算量,在医疗病历分析、法律案例检索等RAG场景中吞吐量提升27倍,推动LLM长文本应用落地。

快手Keye-VL 1.5开源:0.1秒定位+128K窗口重新定义视频AI

快手Keye-VL 1.5开源,重新定义视频AI能力边界。该多模态模型凭借128K超长上下文窗口,可流畅处理数小时长视频,结合Slow-Fast双路编码与3DRoPE时序编码,实现0.1秒级帧级定位精度。在快手日均4亿条视频审核场景中,违规物品定位误差仅0.05秒,误判率低至0.12%;电商领域通过精准锁定商品特写片段,用户点击转化率提升23%。模型支持轻量化部署,INT4量化版本仅需10GB显存即可运行,中文多模态任务表现突出,已整合至LlamaIndex、LangChain工具链。其开源推动视频理解从“能用”迈向“好用”,为内容审核、智能剪辑、长视频分析等领域提供高效技术范式。