持续学习[2]

强化学习(RL)缓解大模型灾难性遗忘:OpenAI、Meta等验证保守更新机制

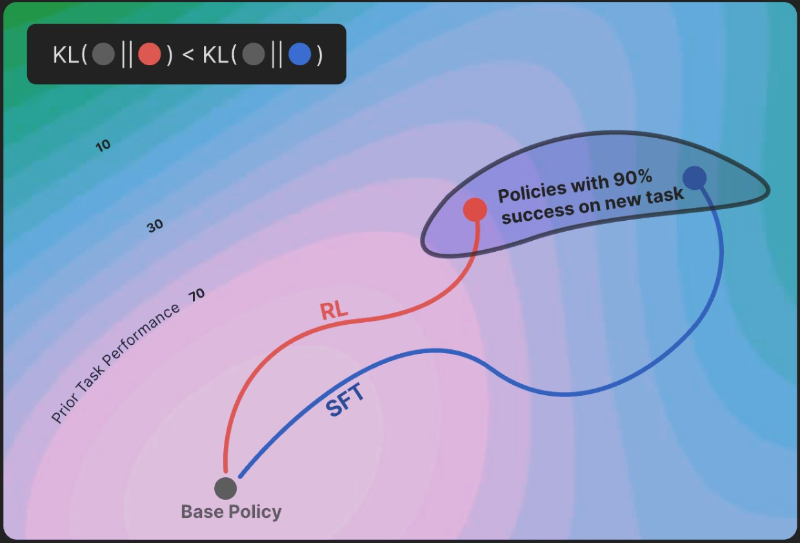

大模型持续学习面临“灾难性遗忘”难题,即学习新任务时易丢失旧知识,传统监督微调(SFT)因参数更新偏向新任务,常导致旧任务保留率不足60%。而强化学习(RL)通过KL散度最小化机制实现“保守更新”,让新模型分布贴近原始知识分布,有效缓解遗忘。实验显示,RL在新任务准确率与SFT持平(约92%)的情况下,旧任务保留率提升20%+,如数学推理与代码生成任务保留率达81.7%。目前OpenAI、Meta、Google等企业已将RL融入微调流程,如RLHF中的KL惩罚项、“螺旋课程微调”等。尽管存在多任务冲突、训练成本等挑战,RL仍为构建“终身学习型AI”提供关键路径,推动大模型从“一次性学习”向持续进化跨越。

中科院自动化所联合香港院AI中心破解多模态大模型灾难性遗忘难题

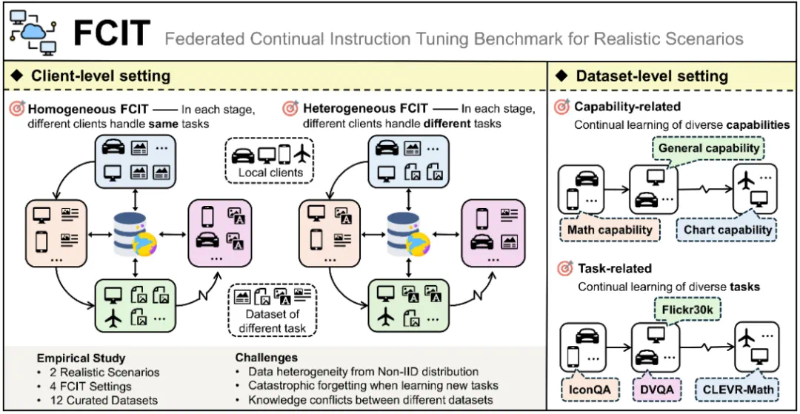

多模态大模型在学习新任务时易出现“灾难性遗忘”,导致旧知识丢失。中科院自动化所团队构建“理论-工具-实践”三位一体体系破解此难题:发布生成式AI持续学习全景综述,涵盖LLMs、MLLMs等四大模型类型;提出UCIT/FCIT评估基准,解决数据泄露与联邦场景评测问题;研发HiDe-LLaVA方法,分层优化仅调2.4%参数,旧任务衰减率低至3.8%。方案降低部署成本,保障医疗、自动驾驶等关键任务稳定,开源资源推动行业创新,为AI“终身学习”提供新范式。